Développer ses sens par le toucher numérique

Une nouvelle technologie haptique en test

Le toucher numérique, qu’est-ce que cela signifie? On s’imagine qu’en touchant un écran, on va ressentir des formes, des lettres, des textures, mais cela paraît aujourd’hui encore surréaliste. Or, une recherche franco-suisse à ce sujet est actuellement en cours et s’attache justement à tester une technologie haptique existante avec un groupe de personnes aveugles et malvoyantes. La rédaction de tactuel a voulu en savoir davantage et s’est entretenu avec trois membres de l’équipe de recherche, le Professeur Micah Murray, directeur du Laboratoire d’investigation neurophysiologique, la doctorante de l’UNIL Ruxandra Tivadar et le DrSc Olivier Lorentz, responsable Innovation à la Fondation Asile des aveugles.

Par Carol Lagrange

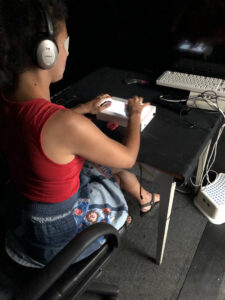

Photo: Laboratoire d’investigation neurophysiologique, Ruxandra Tivadar

En 2015, lors d’une conférence, Olivier Lorentz découvre la technologie haptique développée par la société grenobloise Hap2U. Il s’agit d’une technologie brevetée qui vise à améliorer les expériences dans le monde numérique en intégrant le sens du toucher dans des dispositifs tactiles. A cette époque, la technologie est testée pour pouvoir sentir par exemple les textures de vêtements dans le cadre de ventes en ligne ou encore par rapport à des sensations tactiles liées à des jeux vidéo. Monsieur Lorentz se demande alors si cette technologie ne pourrait pas aussi être utile aux personnes aveugles et malvoyantes.

C’est ainsi qu’une équipe de recherche est constituée et qu’une collaboration naît entre le département de radiologie du Centre hospitalier universitaire et l’Université de Lausanne, la Fondation Asile des aveugles de Lausanne, la société française Hap2U, ainsi que l’Institut de recherche en informatique de gestion de la HES-SO Valais-Wallis à Sierre. L’équipe bénéficie du soutien du Fonds national suisse, de la Fondation Asile des aveugles et d’un mécène conseillé par CARIGEST SA. L’objectif est de reconnaitre et générer une image mentale de l’objet que nous touchons par le biais d’une perception tactile numérique et de favoriser ainsi le développement des sens.

Principe de la technologie

Comme l’explique Ruxandra Tivadar, la technologie est pour le moment intégrée dans une tablette. Il s’agit d’une plaque métallique sous l’écran qui vibre à vitesse ultrasonique et qui, lorsqu’on balaie le doigt sur l’écran, crée une couche d’air qui « déforme » la peau du doigt et donne cette sensation de texture. Le prototype a la forme d’un boîtier, mais est voué à devenir une simple plaquette que l’on pourra emporter partout avec soi.

Applications pour les personnes aveugles et malvoyantes

Les chercheurs sont en train de tester la technologie avec un groupe de personnes aveugles et malvoyantes. Celle-ci pourrait par exemple grandement faciliter l’apprentissage d’une trajectoire, la représentation de l’espace et permettre aux personnes concernées d’appréhender la géométrie plus facilement. Par sessions individuelles de trois heures, Ruxandra Tivadar entraîne les personnes en situation de handicap visuel à utiliser la technologie et à se familiariser avec elle. Une phase de test est également comprise dans ce temps, à savoir que les testeurs doivent réagir à diverses stimulations pour comprendre comment se forme ce type de navigation tactile. Chez les personnes aveugles et malvoyantes, il y a une zone du cortex qui n’est plus active, mais on sait que le toucher peut activer le cerveau visuel pour que la personne puisse distinguer des lettres, des textures, des couleurs même.

La sensation tactile comme compensation sensorielle

Lorsqu’une personne ne peut plus utiliser sa vue, elle compense généralement par son sens de l’ouïe. Selon le Professeur Murray, les technologies auditives existent bien sûr. Mais le décodage auditif est souvent très fatigant et il nécessite que la personne ne se concentre que sur le décodage et pas sur les sons dans l’environnement. À cet égard, l’utilisateur peut constater qu’il a moins de contrôle sur les informations décodées. En revanche, étant donné que le toucher est contrôlé par la personne, il peut donner une impression plus grande de contrôle et donc d’indépendance. Ce qui reste à déterminer, c’est quelle information est la mieux transformée en son ou en toucher pour un individu donné. Le travail du laboratoire du professeur Murray à ce sujet est en cours.

Cette recherche revêt une importance neuroscientifique primordiale pour comprendre comment la plasticité du cerveau peut être utilisée en termes de mécanismes. Dans ce projet, on étudie par imagerie du cerveau et avec un objectif appliqué quelles sont les liaisons entre les différentes parties du cerveau.

Prochaines étapes

L’équipe teste actuellement cette technologie, non seulement dans des simulateurs de conduite pour améliorer la sécurité routière des personnes voyantes, mais aussi dans des unités et des écoles pour personnes malvoyantes et aveugles afin de faciliter la navigation indépendante en complément de cartes tactiles en 3D, ainsi que pour améliorer les approches existantes de l’enseignement de la lecture, de la géométrie et de la reconnaissance d’objets. Si les tests s’avèrent concluants, cette technologie pourrait être mise sur le marché d’ici à trois ans et être ainsi à la disposition des enseignants spécialisés, des experts en réadaptation, des proches et des personnes aveugles et malvoyantes.

Une première étude de validation de la technologie a été publiée en mars dans la revue Frontiers in Integrative Neuroscience https://www.frontiersin.org/articles/10.3389/fnint.2019.00007/full